告别付费 AI!Ollama + DeepSeek 让你轻松搭建免费 AI 助手

写在前面

“老板,这个月的 ChatGPT 订阅又该续费了…” “等等,能不能用点免费的替代方案?” “免费的质量不太好吧?” “那公司也不让用 ChatGPT,说数据安全有风险…”

是不是经常遇到这样的对话?确实,AI 助手已经成为我们工作中不可或缺的工具,但订阅费用、数据安全等问题一直困扰着我们。今天,我要分享一个有趣的发现:使用 Ollama + DeepSeek,你可以在自己的电脑上搭建一个完全免费、性能强劲的 AI 助手。

初识 AI 助手

还记得刚入行时的场景吗?遇到不懂的技术概念,翻文档、查 Stack Overflow、问同事…而现在,有了 AI 助手,这些问题都变得简单了。就像有一个经验丰富的老师,随时在你身边,不厌其烦地解答各种问题。

不过,市面上的 AI 助手要么收费不菲,要么需要联网使用。有没有一种方案,既免费,又能保护数据安全呢?答案就是:在自己的电脑上部署一个 AI 助手。

Ollama + DeepSeek:完美搭档

说到本地部署 AI,就不得不提 Ollama 和 DeepSeek 这对黄金搭档。

Ollama:本地 AI 的最佳选择

Ollama 是一个强大的开源项目,它让在本地运行 AI 大语言模型变得异常简单。它的主要特点包括:

简单易用

- 一行命令完成安装

- 模型下载全自动

- 使用方式类似 Docker,熟悉的 pull/run 命令

功能丰富

- 支持多种开源模型

- 提供 REST API 接口

- 支持自定义模型配置

- 可以通过 Modelfile 定制模型行为

性能优化

- 支持 GPU 加速

- 内存使用优化

- 支持量化模型,降低资源占用

开发友好

- 提供多语言 SDK

- 支持流式输出

- 易于集成到现有项目

安全可靠

- 完全离线运行

- 数据本地存储

- 开源代码可审计

最重要的是,Ollama 是完全免费的,而且所有的对话都在你自己的电脑上完成,数据安全完全不用担心。它就像是一个万能的 AI 播放器,你可以在上面运行各种 AI 模型,从轻量级的对话助手到强大的代码生成器,应有尽有。

DeepSeek:实力派新秀

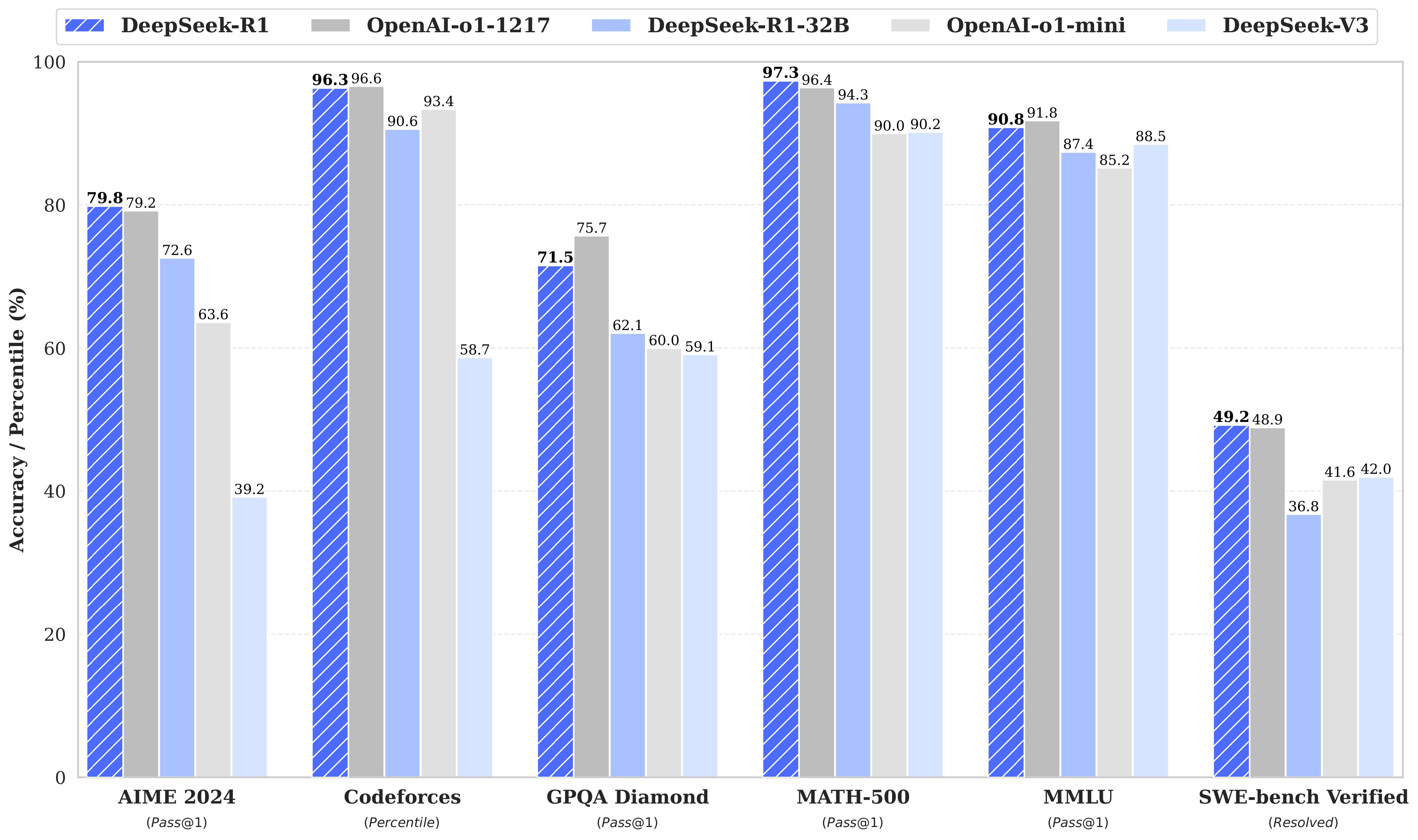

DeepSeek 是一个令人惊喜的发现。它是 DeepSeek 团队开发的第一代推理模型,在数学、编程和推理任务上的表现可以媲美 OpenAI 早期模型。看看这张性能对比图就知道了:

从图中可以看出,DeepSeek 在多个方面都表现出色,尤其是在代码能力和推理能力上,甚至超过了一些知名的商业模型。

更让人惊喜的是,DeepSeek 团队发现了一个有趣的现象:大模型的推理模式可以被提炼到小模型中。这意味着什么呢?简单说,就是他们可以把大模型的"聪明才智"教给小模型,让小模型也能表现得很出色。他们用这种方法创建了一系列不同大小的模型:

- DeepSeek-R1-Distill-Qwen-1.5B:入门级选手,适合普通笔记本

- DeepSeek-R1-Distill-Qwen-7B:主力选手,日常使用的最佳选择

- DeepSeek-R1-Distill-Llama-8B:基于 Llama 的特别版本

- DeepSeek-R1-Distill-Qwen-14B:性能更强,适合专业用户

- DeepSeek-R1-Distill-Qwen-32B:企业级选手

- DeepSeek-R1-Distill-Llama-70B:超大杯,适合高性能服务器

- DeepSeek-R1-671B:终极版本,堪比商业大模型

最棒的是,这些模型都是开源的,而且采用了非常友好的 MIT 许可证。这意味着你可以:

- 免费使用,包括商业用途

- 随意修改和改进

- 甚至可以用来训练你自己的 AI 模型

我的电脑能用吗?

说到这里,你可能会担心:“我的电脑能跑得动吗?“别担心,我们来看看具体的配置要求。

如果你是在校学生或编程新手,用普通笔记本就够了:

- 8GB 内存就能跑起来

- 硬盘预留 10GB 空间

- 选择 DeepSeek 1.5B 版本就好

- 完全能满足学习和日常使用

对于日常工作的开发者,建议这样的配置:

- 16GB 内存会更流畅

- 留出 20GB 硬盘空间

- 最好有独立显卡

- 可以愉快地使用 DeepSeek 7B 版本

- 性能足够应对各种开发任务

如果你是专业团队,想要更强大的性能:

- 32GB 以上的内存

- 50GB 硬盘空间

- 配备独立显卡

- 可以运行 DeepSeek 14B 及更大的版本

- 适合处理复杂的企业级任务

三步搞定安装

安装过程超级简单,我们一步步来:

第一步:安装 Ollama

用苹果电脑的朋友,打开终端输入:

| |

Linux 用户也很简单:

| |

Windows 用户需要先装个 WSL2(就是 Windows 的 Linux 子系统),然后按 Linux 的方式安装。

第二步:下载模型

根据你的电脑配置,选择合适的版本:

| |

第三步:开始对话

| |

AI 助手的日常应用

装好之后,这个 AI 助手能帮我们做什么呢?让我们看几个实际的例子。

代码优化小能手

比如你写了这样一段 Python 代码:

| |

AI 会建议你改成:

| |

不仅告诉你怎么改,还会解释为什么:代码更简洁、性能更好、更符合 Python 的编程风格。

技术概念讲解员

当你问:“微服务是什么?” AI 会用生动的比喻来解释: “想象一个大型餐厅,如果所有工作都由一个厨师完成,从切菜到炒菜再到端盘子,效率肯定不高。但如果我们把工作分给不同的人:有人专门切菜,有人专门炒菜,有人专门传菜,每个人专注自己的工作,整个餐厅就能高效运转。这就是微服务的思想…”

文档写作助手

需要写 API 文档?AI 能帮你生成标准格式的文档。 要写技术方案?AI 能帮你梳理思路,考虑各个方面的问题。

使用小技巧

经过一段时间的使用,我总结了一些实用的小技巧:

让对话更有效

就像和同事交流一样,和 AI 对话也要讲究方式:

- 说明你的背景,比如"我是前端新手”

- 描述具体场景,比如"这是一个电商项目”

- 提供必要信息,比如"系统每天要处理 10 万订单"

处理常见问题

下载慢? 别着急,选个网络好的时间下载,下载完就可以一直用了。实在等不及,可以先试试小一点的版本。

运行慢?

- 关掉不必要的程序,给 AI 多点资源

- 选择适合电脑配置的版本

- 实在卡,就考虑升级配置

回答不够准?

- 多提供一些背景信息

- 换个方式提问

- 让 AI 一步步思考

写在最后

有了这个 AI 助手,你就相当于:

- 随时有个技术顾问在身边

- 不用担心数据泄露的风险

- 省下了不少订阅费用

对于正在学习编程的新手,它能帮你理解概念、改进代码; 对于工作中的开发者,它能提高效率、解决问题; 对于对 AI 感兴趣的朋友,它是一个很好的入门工具。

现在,就开始你的 AI 助手之旅吧!

参考资源

- Ollama 官方模型库:https://ollama.com/library/deepseek-r1

- DeepSeek 官网:https://deepseek.com

- Ollama 项目主页:https://github.com/ollama/ollama

许可证说明

DeepSeek-R1 系列模型采用 MIT 许可证,支持商业使用,允许任何修改和衍生工作。需要注意的是:

- Qwen 系列模型(1.5B/7B/14B/32B)是基于 Apache 2.0 许可证的 Qwen-2.5 系列模型,使用 DeepSeek-R1 生成的 80 万样本进行微调得到

- Llama 8B 模型是基于 llama3.1 许可证的 Llama3.1-8B-Base 模型

- Llama 70B 模型是基于 llama3.3 许可证的 Llama3.3-70B-Instruct 模型